NVIDIA H200 NVL é recomendada para projetos de rack corporativo com menor consumo de energia e resfriamento a ar e oferece inferência de modelos de linguagem grande até 1,7 vezes mais rápida e 1,3 vezes mais desempenho em aplicações de computação de alto desempenho

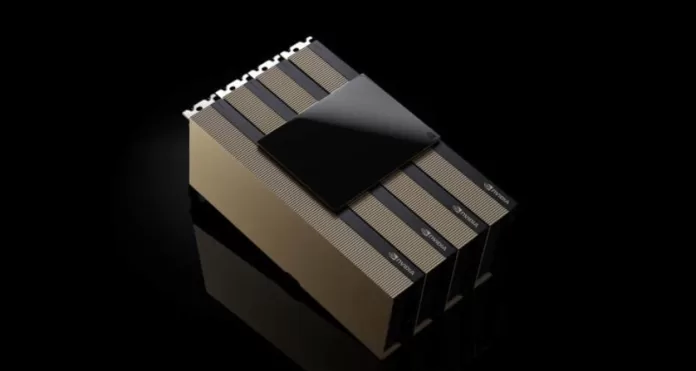

Durante a conferência Supercomputing 2024, a NVIDIA anuncia a disponibilidade da GPU NVIDIA H200 NVL PCIe – a mais recente adição à família Hopper. A H200 NVL é ideal para organizações com data centers que buscam designs de rack corporativo refrigerados a ar de baixa potência com configurações flexíveis para fornecer aceleração para cada carga de trabalho de IA e HPC, independentemente do tamanho.

De acordo com uma pesquisa recente, cerca de 70% dos racks corporativos são de 20 kW ou menos e usam resfriamento a ar. Isso faz com que as GPUs PCIe sejam essenciais, pois oferecem granularidade na implementação de nós, seja usando uma, duas, quatro ou oito GPUs, permitindo que os data centers tenham mais capacidade de computação em espaços menores. As empresas podem então usar seus racks existentes e selecionar o número de GPUs que melhor atenda às suas necessidades.

As empresas podem usar a H200 NVL para acelerar as aplicações de IA e HPC e, ao mesmo tempo, melhorar a eficiência energética por meio da redução do consumo de energia. Com um aumento de 1,5x na memória e 1,2x na largura de banda em relação à NVIDIA H100 NVL, as empresas podem usar a H200 NVL para ajustar os LLMs em poucas horas e oferecer um desempenho de inferência até 1,7x mais rápido. Para cargas de trabalho HPC, o desempenho é aumentado em até 1,3x em relação à H100 NVL e 2,5x em relação à geração da arquitetura NVIDIA Ampere.

Complementando a potência bruta do H200 NVL está a tecnologia NVIDIA NVLink. A última geração do NVLink oferece comunicação entre GPUs 7 vezes mais rápida do que o PCIe de quinta geração, proporcionando maior desempenho para atender às necessidades de HPC, inferência de modelos de linguagem ampla e ajuste fino.

A NVIDIA H200 NVL é combinada com poderosas ferramentas de software que permitem que as empresas acelerem as aplicações de IA para HPC. Ele vem com uma assinatura de cinco anos do NVIDIA AI Enterprise, uma plataforma de software nativa do cloud para o desenvolvimento e a implantação de IA de produção. O NVIDIA AI Enterprise inclui os microsserviços NVIDIA NIM para a implantação segura e confiável da inferência de modelos de IA de alto desempenho.

Com o H200 NVL, a NVIDIA informa que oferece às empresas uma plataforma de pilha completa para desenvolver e implantar suas cargas de trabalho de AI e HPC.

Os clientes estão observando um impacto significativo em vários casos de uso de IA e HPC em todos os setores, como agentes visuais de IA e chatbots para atendimento ao cliente, algoritmos de negociação para finanças, imagens médicas para melhor detecção de anomalias na área da saúde, reconhecimento de padrões para fabricação e imagens sísmicas para organizações científicas federais.

简体中文

简体中文 Nederlands

Nederlands English

English Français

Français Deutsch

Deutsch Italiano

Italiano Русский

Русский Español

Español