Poucas tecnologias se infiltraram no mundo dos negócios tão rapidamente – e com tanto entusiasmo por parte dos líderes – quanto a Inteligência Artificial (IA) e o Machine Learning (ML). De acordo com alguns estudos, dois terços das empresas já estão usando IA generativa e citando seus benefícios, como ganhos de produtividade e melhor gestão do relacionamento com o cliente.

Porém, com o interesse pela IA e pelo ML, surgem receios com a segurança cibernética e a privacidade. Os líderes apontam consistentemente a proteção como uma das principais preocupações ao adotar a IA generativa. Até mesmo os CISOs, que estão acostumados com os detalhes das mudanças tecnológicas em suas organizações, ficam inseguros pois precisam entender os detalhes da IA, equilibrar a inovação e garantir que todas as mudanças tenham um impacto líquido positivo em seus negócios no longo prazo. Sem a base adequada ou o entendimento de como proteger seus sistemas de IA e abordar as principais dores, a inovação fica mais lenta ou até mesmo travada.

Para entender melhor, separei alguns insights interessantes que reuni ao conversar com CISOs globais sobre esse problema:

Por que os CISOs estão "desacelerando" a IA?

As preocupações dos CISOs se resumem em dois problemas principais: devido a uma falta de direcionamento específico sobre IA, os especialistas são forçados a operar sem conhecimento suficiente nessa área tão importante. A maior parte das orientações, incluindo estruturas, de organizações internacionais e das principais empresas de tecnologia, faz um excelente trabalho ao organizar os riscos em sistemas de IA e ML no mais alto nível. Entretanto, muitas delas não têm a especificidade para a execução de que os líderes técnicos precisam no momento.

Também é nítido que a IA ainda é muito nova para que a maioria dos CISOs tenha tido tempo ou espaço para entender claramente o que o sistema implica ou por onde começar com a segurança – e o lado comercial de suas organizações pode não ter tanta paciência quando se trata de começar a usar essa ferramenta. É como se os CISOs fossem instruídos a "proteger o prédio" sem nenhum detalhe sobre o edifício ou o que eles estão de fato protegendo, e sem o contexto necessário – como quantos andares ele tem, por exemplo; como são as portas; como é a área ao redor; etc. Também já vi CISOs debaterem se a proteção da IA é realmente diferente daquelas de aplicações de sistemas tradicionais. Embora os controles de proteção da IA pareçam semelhantes aos de outros sistemas no que diz respeito a como e o que proteger, essa lacuna de conhecimento deixa os CISOs sem saber onde devem aplicar a segurança.

Sem entender a diferença entre dados de teste e dados de validação ou um catálogo de recursos e um de modelos, tendo disponível apenas orientações de alto nível, juntamente com um novo e assustador paradigma, estamos vendo um padrão de alguns CISOs receosos. Isso é esperado, uma vez que os seres humanos são programados para temer o desconhecido, mas não precisa ser assim.

O que precisamos: uma estrutura técnica holística para a segurança de IA

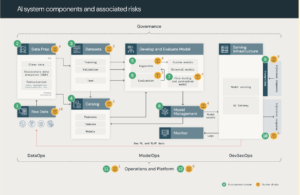

A estrutura de segurança de IA busca fornecer a orientação necessária para entender as principais questões em relação ao trabalho de proteção das equipes dos CISOs. Com ela, é possível descrever os 12 componentes fundamentais de um sistema de IA e ML centrado em dados e mapear um total de 55 riscos técnicos neles.

Em determinadas situações, apenas alguns riscos se aplicam de fato. Por exemplo, ao se concentrar em um subconjunto de riscos, o universo de controles necessários para proteger um sistema de IA se torna mais viável.

Seguindo sua estrutura, os quatro subsistemas fundamentais da IA são:

-

Operações de dados: ingestão, transformação e garantia da segurança e da governança de informações;

-

Operações de modelo: criação de formatos personalizados, aquisição em um mercado de modelos ou uso de LLMs SaaS (como o OpenAI);

-

Implementação e veiculação: criação segura de imagens, isolamento e veiculação de modelos, bem como dimensionamento automatizado, limitação de taxas e monitoramento dos formatos implementados;

-

Operações e plataforma: gerenciamento e correção de vulnerabilidades da plataforma, isolamento de modelos e controles para o sistema.

A partir daí, é possível visualizar e compreender os riscos correspondentes a cada componente fundamental. Por exemplo, essas operações abrangem 13 riscos potenciais, incluindo roubo, inversão e vazamento de ativos de modelos.

Essa abordagem ajuda a lidar com as diferentes necessidades das empresas quando se trata de proteger a IA, assim como preparar um edifício para desastres naturais como parte do processo de proteção. Voltando ao exemplo das operações que citei anteriormente, uma empresa que investiu muito na criação de um modelo proprietário estará mais preocupada com o roubo e com a segurança do próprio. Por outro lado, uma companhia que tenha uma infinidade de dados de treinamento valiosos pode estar mais preocupada em proteger suas informações sobre as práticas.

Guardrails para se adaptar a um cenário em constante mudança

É importante ressaltar que, ao adotar qualquer estrutura, é fundamental garantir que ela seja dinâmica e possa mudar junto com o cenário; à medida que as regulamentações se consolidam em relação à forma como as empresas usam ou criam IA, as ameaças e as vulnerabilidades também se transformam. Dessa forma, os CISOs precisam estar adequadamente preparados para responder às mudanças em um piscar de olhos. Além disso, ao dividir o sistema e analisar os riscos em um nível holístico, esses profissionais podem entender melhor quais são os componentes e os perigos afetando o sistema.

Há uma razão pela qual existem tantas incertezas em relação à segurança em IA: é difícil, seja devido a partes móveis, sistemas que parecem desconhecidos ou as muitas áreas cinzentas nas regulamentações, bem como na conformidade atualmente. Por meio de uma compreensão completa de quais componentes fazem parte da IA, como eles funcionam juntos e quais perigos distintos a IA apresenta, é possível entender melhor quais elementos, ameaças e riscos são de maior prioridade para sua organização e garantir que esses controles estejam em vigor.

Os CISOs merecem dizer "sim" à inovação e, ao usar estruturas robustas e dinâmicas para iluminar um caminho a seguir, devem poder orientar com segurança os dados de sua companhia e as jornadas de IA, mesmo com a evolução do cenário.

Omar Khawaja, vice-presidente de segurança e Field CISO da Databricks.