A Amazon Web Services e a NVIDIA anunciam uma colaboração de várias partes focada na construção da infraestrutura de inteligência artificial (IA) sob demanda mais expansível do mundo, otimizada para treinar grandes modelos de linguagem (LLMs) cada vez mais complexos e desenvolver aplicações de IA generativa.

O trabalho conjunto apresenta instâncias P5 da Amazon Elastic Compute Cloud (Amazon EC2) de próxima geração com GPUs NVIDIA H100 Tensor Core, além de rede e capacidade de expansão de última geração da AWS, que fornecerão até 20 exaFLOPS de desempenho de computação para construção e treinamento dos maiores modelos de deep learning. As instâncias P5 serão as primeiras instâncias baseadas em GPU a aproveitar a rede Elastic Fabric Adapter (EFA) de segunda geração da AWS, que fornece 3.200 Gbps de taxa de transferência de rede de baixa latência e alta largura de banda, permitindo que os clientes dimensionem até 20.000 GPUs H100 em UltraClusters EC2 para acesso sob demanda ao desempenho de classe de supercomputador para IA.

"A AWS e a NVIDIA colaboram há mais de 12 anos para fornecer soluções econômicas de grande escala baseadas em GPU sob demanda para várias aplicações, como IA/ML, gráficos, jogos e HPC", diz Adam Selipsky, CEO da AWS. "A AWS tem uma experiência inigualável no fornecimento de instâncias baseadas em GPU que desafiam os limites da capacidade de expansão com cada geração sucessiva, com muitos clientes dimensionando as cargas de trabalho de treinamento de machine learning para mais de 10.000 GPUs atualmente. Com a EFA de segunda geração, os clientes poderão expandir suas instâncias P5 para mais de 20.000 GPUs NVIDIA H100, levando recursos de supercomputador sob demanda para clientes que vão desde startups até grandes empresas."

"A computação acelerada e a IA chegaram na hora certa. A computação acelerada fornece aumentos de velocidade de função em etapas enquanto reduz o custo e a energia à medida que as empresas se esforçam para fazer mais com menos. A IA generativa despertou as empresas para reinventar seus produtos e modelos de negócios e ser um agente ativo na ruptura", explica Jensen Huang, fundador e CEO da NVIDIA. "A AWS é um parceiro de longa data e foi o primeiro provedor de serviços de nuvem a oferecer GPUs NVIDIA. Estamos entusiasmados em combinar nossa experiência, escala e alcance para ajudar os clientes a aproveitar a computação acelerada e a IA generativa para atrair as enormes oportunidades futuras".

Novos clusters de supercomputação

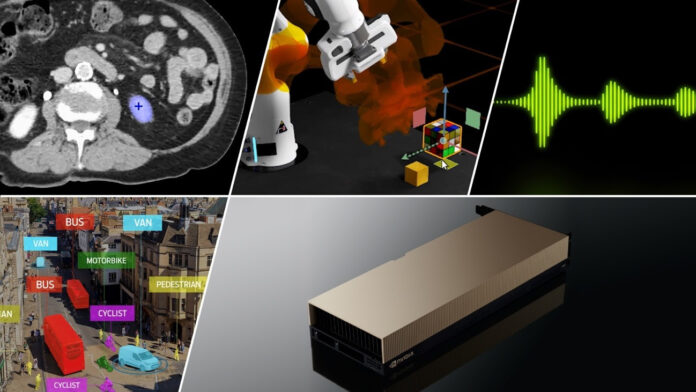

As novas instâncias P5 têm base em mais de uma década de colaboração entre a AWS e a NVIDIA, fornecendo a infraestrutura de IA e HPC, e em quatro colaborações anteriores em instâncias P2, P3, P3dn e P4d(e). As instâncias P5 são a quinta geração de ofertas da AWS equipadas com GPUs NVIDIA e surgem quase 13 anos após a implantação inicial de GPUs NVIDIA, começando com instâncias CG1.

As instâncias P5 são ideais para treinar e executar inferência para LLMs cada vez mais complexos e modelos de visão computacional por trás das aplicações de IA generativa mais exigentes e com uso intenso de computação, incluindo resposta a perguntas, geração de código, geração de vídeo e imagem, reconhecimento de fala e muito mais.

Criadas especificamente para empresas e startups que correm para levar inovação alimentada por IA ao mercado de maneira expansível e segura, as instâncias P5 apresentam oito GPUs NVIDIA H100 com capacidade para 16 petaFLOPs de desempenho de precisão mista, 640 GB de memória de alta largura de banda e conectividade de rede de 3.200 Gbps (oito vezes mais que a geração anterior) em uma única instância da EC2. O desempenho aprimorado das instâncias P5 acelera o tempo de treinamento de modelos de machine learning (ML) em até seis vezes (reduzindo o tempo de treinamento de dias para horas), e a memória de GPU adicional ajuda os clientes a treinar modelos maiores e mais complexos. Espera-se que as instâncias P5 reduzam o custo para treinar modelos de ML em até 40% em relação à geração anterior, proporcionando aos clientes maior eficiência em relação a ofertas de nuvem menos flexíveis ou sistemas locais caros.

"Com o avanço da IA generativa, o mercado precisa estar preparado para lidar com a demanda dessa nova tecnologia. A NVIDIA, com sua capacidade computacional, auxilia e fornece recurso para melhorar o desempenho das empresas nesse processo", destaca Marcio Aguiar, diretor da divisão Enterprise da NVIDIA para América Latina.

As instâncias P5 da Amazon EC2 são implantadas em clusters de hiperescala chamados UltraClusters EC2, compostos pela computação, rede e armazenamento de mais alto desempenho na nuvem. Cada UltraCluster EC2 é um dos supercomputadores mais poderosos do mundo, permitindo que os clientes executem seus treinamentos de ML de vários nós mais complexos e cargas de trabalho de HPC distribuídas. Eles apresentam rede sem bloqueio em escala de petabits, equipada com EFA da AWS, uma interface de rede para instâncias da Amazon EC2 que permite que os clientes executem aplicações que exigem altos níveis de comunicação entre nós em escala na AWS.

O sistema operacional (SO) personalizado da EFA ignora a interface de hardware, e a integração com o NVIDIA GPUDirect RDMA melhora o desempenho das comunicações entre instâncias, diminuindo a latência e aumentando a utilização da largura de banda, o que é fundamental para dimensionar o treinamento de modelos de deep learning em centenas de nós P5.

Com instâncias P5 e EFA, as aplicações de ML podem usar a NVIDIA Collective Communications Library (NCCL) para expandir para até 20.000 GPUs H100. Como resultado, os clientes obtêm o desempenho de aplicações de clusters HPC locais com a elasticidade sob demanda e a flexibilidade da AWS. Além desses recursos de computação de ponta, os clientes podem usar o portfólio de serviços mais amplo e aprofundado do setor, como Amazon S3 para armazenamento de objetos, Amazon FSx para sistemas de arquivos de alto desempenho e Amazon SageMaker para criar, treinar e implantar aplicações de deep learning. As instâncias P5 estarão disponíveis nas próximas semanas em uma pré-visualização limitada.

Com as novas instâncias P5 da EC2, clientes como Anthropic, Cohere, Hugging Face, Pinterest e Stability AI poderão criar e treinar os maiores modelos de ML em escala. A colaboração por meio de gerações adicionais de instâncias EC2 ajudará startups, empresas e pesquisadores a expandir perfeitamente para atender às suas necessidades de ML.

A Anthropic constrói sistemas de IA confiáveis, interpretáveis e orientáveis que trarão muitas oportunidades de criar valor comercialmente e em benefício da sociedade. "Na Anthropic, estamos trabalhando para construir sistemas de IA confiáveis, interpretáveis e orientáveis. Embora os grandes sistemas gerais de IA de hoje possam ter benefícios significativos, eles também podem ser imprevisíveis, não confiáveis e opacos. Nosso objetivo é progredir nessas questões e implantar sistemas que as pessoas considerem úteis", conta Tom Brown, cofundador da Anthropic. "Nossa organização é uma das poucas no mundo que está construindo modelos básicos em pesquisa de deep learning. Esses modelos são muito complexos e, para desenvolver e treinar esses modelos de ponta, precisamos distribuí-los com eficiência em grandes clusters de GPUs. Hoje, estamos usando instâncias P4 da Amazon EC2 de maneira extensa, e estamos entusiasmados com o próximo lançamento de instâncias P5. Esperamos que ofereçam benefícios substanciais de preço e desempenho em relação às instâncias P4d, e elas estarão disponíveis na escala massiva necessária para a construção de grandes modelos de linguagem (LLMs) de próxima geração e produtos relacionados."

A Cohere, pioneira líder em IA de linguagem, capacita todos os desenvolvedores e empresas a criar produtos incríveis com a tecnologia de processamento de linguagem natural (NLP) líder mundial, mantendo seus dados privados e seguros. "A Cohere lidera a tarefa de ajudar todas as empresas a aproveitar o poder da linguagem de IA para explorar, gerar, pesquisar e agir sobre as informações de maneira natural e intuitiva, implantando em várias plataformas de nuvem no ambiente de dados que funciona melhor para cada cliente", ressalta Aidan Gomez, CEO da Cohere. "As instâncias P5 da Amazon EC2 equipadas com NVIDIA H100 vão liberar a capacidade das empresas de criar, crescer e dimensionar mais rapidamente com seu poder de computação combinado com o LLM de última geração da Cohere e os recursos de IA generativa."

A Hugging Face tem a missão de democratizar o bom machine learning. "Como a comunidade de código aberto para machine learning que mais cresce, agora fornecemos mais de 150.000 modelos previamente treinados e 25.000 conjuntos de dados em nossa plataforma para NLP, visão computacional, biologia, aprendizado por reforço e muito mais", afirma Julien Chaumond, CTO e cofundador da Hugging Face. "Com avanços significativos em grandes modelos de linguagem (LLMs) e IA generativa, estamos trabalhando com a AWS para criar e contribuir com os modelos de código aberto do futuro. Estamos ansiosos para usar as instâncias P5 da Amazon EC2 por meio do Amazon SageMaker em escala em UltraClusters com EFA para acelerar a entrega de novos modelos básicos de IA para todos."

Hoje, mais de 450 milhões de pessoas em todo o mundo usam o Pinterest como uma plataforma de inspiração visual para comprar produtos personalizados ao seu gosto, encontrar ideias para criar no mundo offline e descobrir os criadores mais inspiradores. "Usamos o deep learning extensivamente em nossa plataforma para casos de uso, como rotular e categorizar bilhões de fotos que são carregadas em nossa plataforma, além de pesquisa visual que fornece a nossos usuários a capacidade de ir da inspiração à ação", diz David Chaiken, arquiteto chefe do Pinterest. "Criamos e implantamos esses casos de uso aproveitando as instâncias de GPU da AWS, como as P3 e as P4d mais recentes. Estamos ansiosos para usar as instâncias P5 da Amazon EC2 com GPUs H100, EFA e Ultraclusters para acelerar o desenvolvimento de nossos produtos e trazer novas experiências baseadas em IA empática para nossos clientes."

Como líder em desenvolvimento e implantação de modelos de IA multimodais e de código aberto, a Stability AI colabora com parceiros dos setores público e privado para levar essa infraestrutura de última geração a um público global. "Na Stability AI, nosso objetivo é maximizar a acessibilidade da IA moderna para inspirar criatividade e inovação globais", afirma Emad Mostaque, CEO da Stability AI. "Inicialmente, fizemos uma parceria com a AWS em 2021 para criar o Stable Diffusion, um modelo latente de difusão de texto para imagem, usando instâncias P4d da Amazon EC2 que empregamos em escala para acelerar o tempo de treinamento do modelo de meses para semanas. À medida que trabalhamos em nossa próxima geração de modelos de IA generativa de código aberto e expandimos para novas modalidades, estamos entusiasmados em usar instâncias P5 do Amazon EC2 em UltraClusters EC2 de segunda geração. Esperamos que as instâncias P5 melhorem ainda mais nosso tempo de treinamento de modelos em até quatro vezes, permitindo-nos oferecer uma IA inovadora mais rapidamente e com um custo menor."

Novos designs de servidor para IA expansível e eficiente

Antes do lançamento da H100, as equipes de engenharia da NVIDIA e da AWS com experiência em campos térmicos, elétricos e mecânicos colaboraram para projetar servidores que aproveitam as GPUs para fornecer IA em escala, com foco na eficiência energética na infraestrutura da AWS. As GPUs são normalmente 20 vezes mais eficientes em termos de energia do que as CPUs para determinadas cargas de trabalho de IA, com a H100 sendo até 300 vezes mais eficiente para LLMs do que as CPUs.

O trabalho conjunto incluiu o desenvolvimento de um design térmico do sistema, segurança integrada e gerenciamento do sistema, segurança com hipervisor acelerado por hardware AWS Nitro e otimizações NVIDIA GPUDirect™ para a estrutura de rede EFA personalizada da AWS.

Com base no trabalho da AWS e da NVIDIA focado na otimização de servidores, as empresas começaram a colaborar em futuros projetos de servidores para aumentar a eficiência de dimensionamento com projetos de sistemas de geração subsequente, tecnologias de resfriamento e capacidade de expansão da rede.